Tramvay İkilemi ve Otonom Araçlarda Ahlaki Seçimler

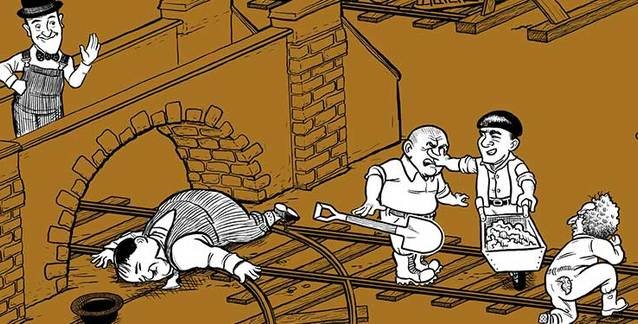

İlk olarak 1967'de Philippa Foot tarafından ortaya atılan Tramvay İkilemi (Trolley Dilemma), günümüzde modern felsefedeki en zor etik sorulardan biri olarak kabul edilmektedir. Bu sorunun ikilemi, otonom araçlar dünyasında da oldukça önemli bir tartışma yaratıyor.

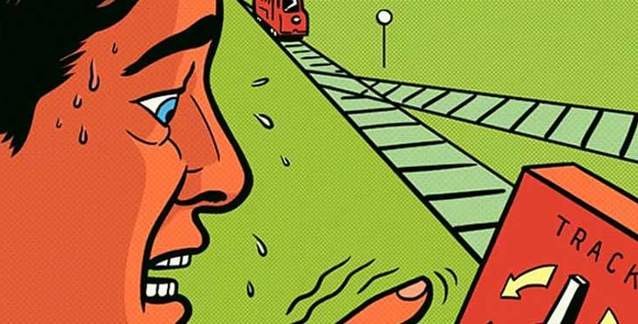

Problem bildiğiniz gibi, bir görgü tanığının, kaçamayacak durumda olan beş kişiye doğru hızla yaklaşan bir sürücüsüz bir tramvay gördüğünde ne yapması gerektiğini soruyor. Tanığın, çekildiğinde, tramvayı sadece bir kişinin bağlı olduğu alternatif bir yola yönlendiren bir kola erişimi bulunuyor. İkileme sebep olan şey ise, masum görgü tanığının, beş kişinin ölümünü izlemesi mi yoksa aktif olarak müdahale edip diğer beş kişiyi kurtarmak için bir kişinin ölümüne neden olması mı gerektiğine derhal karar vermesidir.

Bu çözülmesi kolay bir problem değil. Tabii ki, dürtüsel tepki, yaşamları nicelik olarak değerlendirerek beş yaşamın bir yaşamdan daha önemli olacağına karar vermek olabilir. Ancak, ya bu bir kişi yeni doğmuş bir bebekse ve beş yaşlı insan da 90 yaşındaysa? Bu durum verilen kararları nasıl etkiler?

Otomatik ve otonom araçların önlenemez yükselişleri ile bu sorun, otomobil üreticilerinin kendi kendini süren araçlarını nasıl programlayacaklarına karar verirken etik sorumluluklarını da vurguladığı için yeniden ilgi gördü. Yapay zekâ günümüzde iş, sağlık ve üretim alanlarında kararlar alsa da programcılar, mühendisler ve tasarımcılar artık toplu olarak “karar vericiyi” oluşturuyor ve nihayetinde, öngörülemeyen bir olaya yanıt olarak otomobilin vereceği en uygun yanıtı kodluyor ve entegre ediyor.

Peki yapay zekâ sistemleri, insanlar için ölüm kalım anlamına gelebilecek bağımsız kararlar almak zorunda kalsaydı ne olurdu?

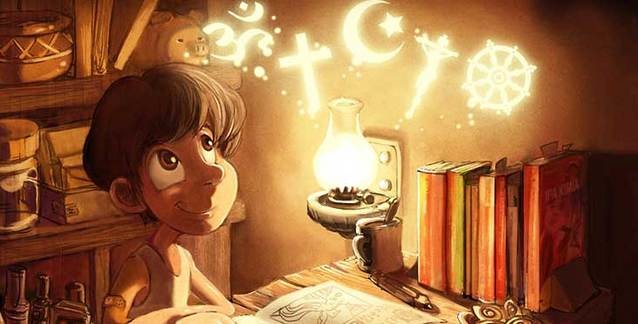

İnsanlardan farklı olarak “robotlar” ahlaki bir vicdandan yoksundur ve kendilerine programlanmış “etik”leri takip eder. Aynı zamanda, insan ahlakı da oldukça değişkendir. Herhangi bir durumda yapılacak “doğru” şey, kime sorduğunuza bağlı olacaktır. Makinelerin bize tam potansiyellerinde yardımcı olmaları için etik davrandıklarından emin olmamız gerekir. Böylece soru şu hale geliyor; AI geliştiricilerinin ve mühendislerinin etiği, AI tarafından verilen kararları nasıl etkiler?

Otonom Sürüşün Geleceği

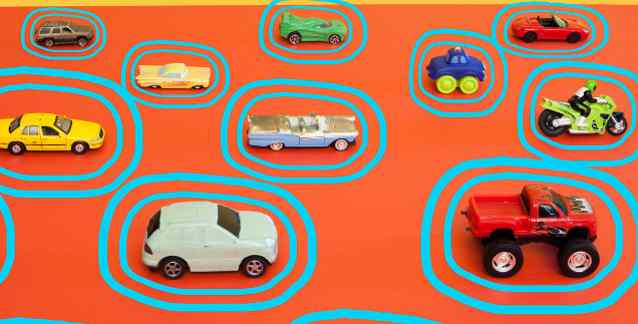

Tamamen otonom olan, kendi kendini sürebilen arabalarla dolu bir gelecek hayal edin. Her şey istendiği gibi giderse yolculuğunuz, sabah işe gidip gelmek, günlük toplantılara hazırlanmak, haberleri takip etmek veya arkanıza yaslanıp rahatlamak için bir fırsat olacaktır.

Ama ya işler ters giderse? Araba bir trafik ışığına yaklaşır, ancak aniden frenler bozulur ve bilgisayarın anlık bir karar vermesi gerekir: yakındaki bir direğe çarparak arabanın içindeki yolcuyu öldürebilir veya devam edip önündeki yayayı öldürebilir. Arabayı kontrol eden bilgisayar, sadece araba sensörleri aracılığıyla toplanan sınırlı bilgilere erişebilecek ve buna göre bir karar vermek zorunda kalacak. Bu ne kadar dramatik görünse de potansiyel olarak bu tür ikilemlerle yüzleşmekten sadece birkaç yıl uzaktayız. Otonom arabalar genellikle daha güvenli sürüş sağlayacaktır, ancak özellikle öngörülebilir bir gelecekte, bu arabaların, yolları insanlı araçlar ve yayalarla paylaşacağı zaman kazalar kaçınılmaz olacaktır.

Örneğin Tesla, planlasa da henüz tam otonom otomobiller üretmeye başlamadı. Çarpışma durumlarında, kontrol bir insan sürücüdeyse Tesla otomobilleri “Otomatik Acil Durum Frenleme” (AEB) sistemini otomatik olarak çalıştırmaz veya devre dışı bırakmaz. Başka bir deyişle, çarpışmaya kendileri sebep olsalar bile, sürücünün eylemleri kesintiye uğramaz. Bunun yerine, araç olası bir çarpışma tespit ederse, harekete geçmesi için sürücüye uyarılar gönderir. Ancak, araç “otomatik pilot” modundayken, yayaları tespit ettiğinde otomatik olarak fren yapmalıdır. Bazıları, otomobilin her olası senaryoda, bir çarpışmayı önlemek için sürücünün eylemlerini geçersiz kılmanın ahlaki bir zorunluluk olduğunu tartışıyor. Ancak bu kararı bizim adımıza otonom bir otomobilin vermesini ister miydik?

Bir Hayatın Değeri

Bir arabanın yapay zekâsı, arabadaki yolcunun ve yayanın göreli "değerini" değerlendirebilseydi nasıl olurdu? Aslında kararı verirken bu değeri dikkate alsaydı, teknik olarak sadece bir maliyet-fayda analizi yapıyor olurdu. Bu durum oldukça endişe verici görünebilir, fakat bunu sağlayabilecek olası teknolojiler günümüzde halihazırda geliştiriliyor. Örneğin, yakın zamanda yeniden markalaştırılan Meta(eski adıyla Facebook) 2 Kasım 2021 tarihine kadar, kişileri kolayca tanımlayabilen oldukça gelişmiş yüz tanıma teknolojisini kullanıyordu.

Bu veriler otonom bir aracın yapay zekâ sistemine dahil edilirse, algoritma her bir ömre bir değer de pekâlâ biçebilir. Bu olasılık, Massachusetts Institute of Technology'deki uzmanlar ve meslektaşları tarafından yürütülen kapsamlı bir 2018 çalışmasında tasvir edilmiştir.

“Moral Machine” deneyi aracılığıyla araştırmacılar, katılımcıları evsiz bir yayayı mı yoksa yönetici vasıflı bir yayayı mı öldüreceklerine karar vermeye zorlayan çeşitli otonom araba senaryoları ortaya koydu. Sonuçlar, katılımcıların seçimlerinin ülkelerindeki ekonomik eşitsizlik düzeyine bağlı olduğunu ortaya çıkardı; daha fazla ekonomik eşitsizlik, evsiz adamın feda edilme olasılığının da daha yüksek olduğu anlamına geliyordu. Bu kadar gelişmiş olmasa da Çin’de bu tür veri toplama uygulamaları ve toplanan verilere göre kişilerin hangi sosyal haklara sahip olduğuna karar veren sosyal kredi sistemi zaten kullanılıyor. Bu konuyu bir sonraki yazımızda detaylı olarak inceleyeceğiz.

Sağlık sektörü, yapay zekânın insanları kurtarabilecek veya zarar verebilecek kararları verdiğini göreceğimiz başka bir alan olacaktır. Günümüzde, tıbbi görüntülemedeki anormallikleri tespit etmek ve doktorların tıbbi bakıma öncelik vermelerine yardımcı olmak için yapay zekâ giderek daha fazla geliştiriliyor. Şimdilik son sözü doktorlar söylüyor, fakat bu teknolojiler daha da geliştiğinde, bir doktor ve yapay zekâ algoritması aynı teşhisi koymazsa ne olacak?

Bu sorunlara bir başka örnek de otomatik bir ilaç hatırlatma sistemidir. Bir hasta ilaçlarını almayı reddederse sistem nasıl tepki vermelidir? Bu, hastanın özerkliğini ve sistemin genel hesap verebilirliğini nasıl etkiler? Yapay zekâ destekli insansız hava araçları ve silahlar da öldürme kararını verebildikleri için etik açıdan endişe vericidir. Bu tür teknolojilerin tamamen yasaklanması mı yoksa düzenlenmesi mi gerektiği konusunda çelişkili görüşler bulunur. Bir kısım, otonom droneların yapabildiklerinin gözetim ile sınırlandırılmasını isterken diğer kısım ise drone ve diğer askeri robotların etik değerlerle programlanmasını istedi. Ancak bu, bir drone’nun veya başka bir robotun yanlışlıkla sivilleri öldürmesi durumunda programcının hesap verebilirliği ile ilgili sorunları gündeme getiriyor.

Felsefi İkilemler

Yapay zekânın vermesi gereken etik kararlarla ilgili birçok felsefi tartışma var. Bunun klasik örneği bahsettiğimiz tramvay problemidir.

Hepimiz genellikle hayatlarımızı değiştirebilecek kararlar vermekte zorlanırız. Bir çalışmada, yanıtlayanın yaşı, cinsiyeti ve kültürü gibi bir dizi faktörün durumlara nasıl tepki verildiğini etkileyebileceği belirtildi. Yapay zekâ sistemleri söz konusu olduğunda, algoritmaların eğitim süreçleri, gerçek dünyada nasıl çalışacakları açısından kritik öneme sahiptir. Bir ülkede, o ülkenin görüşlerinden, siyasetinden, etik ve ahlakından etkilenerek geliştirilen bir sistem, başka bir yerde ve zamanda kullanılmaya uygun değildir. Uçakları kontrol eden veya bir füzeye rehberlik eden bir sistemin, kullanıldığı ortamı temsil eden verilerle eğitildiğine emin olmak isteriz.

Teknoloji uygulamalarındaki başarısızlık ve önyargı örnekleri arasında ırkçı bir sabunluk ve ırkçı otomatik görüntü etiketleme ilk sıralarda yer almaktadır.

Yapay zekâlar “iyi” veya “kötü” değildir. İnsanlar üzerindeki etkileri, geliştiricilerinin etiğine bağlı olacaktır. Dolayısıyla, bundan en iyi şekilde yararlanmak için, “etik” olarak gördüğümüz şey üzerinde bir fikir birliğine varmamız gerekecek. Özel şirketler, kamu kuruluşları ve araştırma kurumlarının etik yapay zekâlar için kendi yönergeleri olsa da, Birleşmiş Milletler, küresel bir etik yapay zekâ çerçevesi sağlamak ve insan haklarının korunmasını sağlamak için "kapsamlı bir küresel standart belirleme aracı" olarak adlandırdıkları şeyi geliştirmeyi öneriyor.- !important Safety Technologies, The “Trolley Problem” of the Self-Driving Industry May Have Found a Solution. https://medium.com/@importanttech/the-trolley-problem-of-the-self-driving-industry-may-have-found-a-solution-30e1d40ce78c (E.T. 26 Nisan 2022)

- Jumana Abu-Khalaf, Paul Haskell-Dowland, The self-driving trolley problem: how will future AI systems make the most ethical choices for all of us? https://theconversation.com/the-self-driving-trolley-problem-how-will-future-ai-systems-make-the-most-ethical-choices-for-all-of-us-170961 (E.T. 26 Nisan 2022)

- Karen Hao, Should a self-driving car kill the baby or the grandma? Depends on where you’re from. https://www.technologyreview.com/2018/10/24/139313/a-global-ethics-study-aims-to-help-ai-solve-the-self-driving-trolley-problem/ (E.T. 26 Nisan 2022)

Dilediğiniz miktarda aylık veya tek seferlik bağış yapabilirsiniz.

Destek OlBunlar da İlginizi Çekebilir